Pour faire fonctionner des systèmes autonomes comme les voitures ou les robots, il faut doter ces machines de systèmes de détection pour leur permettre de s’orienter et de réagir à leur environnement : le LiDAR est une technologie prometteuse.

La vision est l’un des sens les plus importants des êtres humains qui leur permet de percevoir leur environnement et d’acquérir les informations nécessaires avant de procéder à la prise de décision.

Le besoin d’autonomie n’est pas exclusif aux humains, car diverses machines doivent souvent accomplir des tâches complexes avec une intervention humaine minimale. De nombreux secteurs d’activité tels que les transports, l’industrie ou les chaînes logistiques ont besoin de systèmes (véhicules, robots… etc.) capables de circuler dans des environnements complexes ou réaliser des tâches sans être contrôlés par des opérateurs. Imaginez, par exemple, que votre voiture se conduise toute seule sur l’autoroute pendant que vous profitez de votre livre.

Pouvons-nous nous inspirer de la vision humaine pour augmenter l’autonomie des machines et l’efficacité des secteurs opérationnels de nos sociétés ? Cette question ne relève pas de la science-fiction, car il existe une technologie qui permet la reconstruction en temps réel d’une image tridimensionnelle (3D) de notre environnement, imitant nos yeux, mais dépassant par certains aspects les capacités de la vision humaine. Cette technologie c’est la « Détection et télémétrie par lumière » ou « LiDAR » (pour light detection and ranging) et existe depuis les années 60, étant en fait le descendant du Radar utilisé dans les aéroports et les ports pour une navigation sécurisée.

Comment fonctionne un LiDAR ?

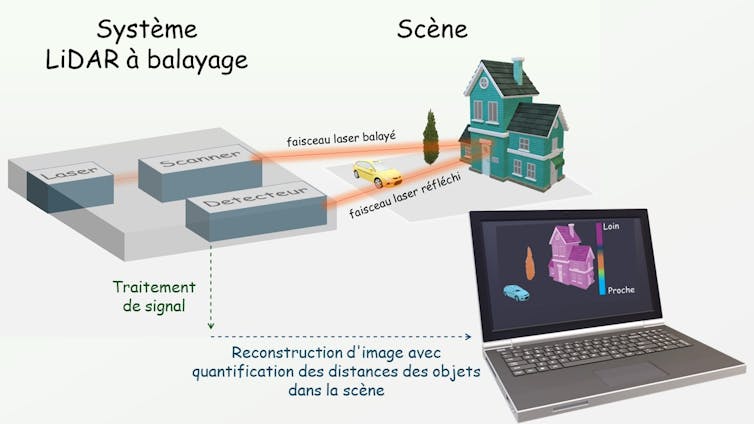

Un type classique est le LiDAR à balayage qui comprend trois sous-systèmes clés : un laser, un scanner, et un détecteur. Contrairement au Radar qui utilise des ondes radio, le LiDAR utilise des impulsions laser de longueur d’onde beaucoup plus courte dans l’infrarouge proche. Le laser balaie point par point les différents objets situés dans une scène.

Illustruation d’un système LiDAR. Le laser balaie la scène et le signal réfléchi est traité pour reconstruire un nuage de points. La profondeur de chaque objet est encodée avec différentes couleurs. Christina Kyrou, Fourni par l’auteur

Enfin, le signal réfléchi par les différents points est dirigé vers le détecteur. Sachant que le laser voyage à la vitesse de la lumière et en calculant le temps pour le trajet aller-retour du signal de la source au détecteur (temps de vol), un LiDAR est capable de déterminer la distance le séparant d’objets présents dans son environnement avec une grande précision. L’acquisition des données LiDAR suivie d’un traitement de signal dédié permet la création d’un nuage de points 3D, offrant une cartographie dynamique des différents événements se produisant dans la scène.

Des voitures, des drones et des robots autonomes

Il est crucial de réduire l’intervention humaine lors de diverses procédures pour des raisons de sécurité ou environnementales. Dans ces cas, les robots et les véhicules « intelligents » sont chargés d’accomplir différentes tâches avec une grande autonomie. Dans un environnement avec plusieurs entités statiques et mobiles, la prise de décision d’un objet dépend des actions des autres objets dans l’espace et dans le temps.

Un exemple est une autoroute, où la décision d’une voiture autonome de freiner en cas d’urgence dépend de la présence d’un obstacle sur son chemin. De manière similaire, dans les infrastructures industrielles, différents robots doivent interagir dynamiquement pour coordonner la production et augmenter la productivité. Un autre cas où une prise de décision sans intervention humaine est nécessaire concerne l’approvisionnement de régions isolées et inaccessibles en biens vitaux tels les médicaments en utilisant des drones aériens. Il faut donc fournir des « yeux » artificiels aux voitures, robots et drones pour permettre leur navigation autonome et fiable.

Les systèmes LiDAR créent des images 3D de leur environnement en temps réel en balayant le laser dans une large gamme spatiale, fournissant des informations sur la position exacte de divers objets dans une scène, facilitant ainsi une prise de décision ultrarapide. Contrairement aux Radars, en raison de leur longueur d’onde d’opération plus courte, les LiDAR offrent une résolution spatiale ultra-haute nécessaire pour détecter de petits objets sur de longues distances. De plus, par rapport aux caméras, les LiDAR fonctionnent même dans des conditions de faible luminosité et fournissent des informations quantitatives sur la distance sans nécessiter le traitement d’image.

Encore des défis à relever

Récemment, Luminar, un fabricant de LiDAR, a annoncé que Tesla contribuait à 10 % de leur chiffre d’affaires grâce aux ventes de LiDAR, montrant le potentiel de cette technologie pour atteindre les voitures vraiment autonomes.

Les LiDAR destinés aux applications à grande échelle nécessitent encore des améliorations techniques pour répondre pleinement à certains besoins. Tout d’abord, ces yeux artificiels doivent être capables de voir sur un large champ de vision. De plus, l’acquisition d’image doit être ultrarapide pour surpasser le temps de perception visuelle humaine, qui est de l’ordre de plusieurs millisecondes.

En même temps, ils doivent résister aux chocs, aux vibrations et aux conditions extrêmes, tout en ayant une faible consommation d’énergie. Enfin, pour l’adoption massive de cette technologie, le faible coût, l’intégrabilité et l’attrait esthétique sont également non négociables.

Le défi majeur pour réaliser des systèmes LiDAR remplissant ces conditions demeure la réalisation de scanners robustes et peu coûteux. Actuellement, le marché est dominé à près de 80 % par des solutions de balayage reposant sur des pièces mobiles (rotation mécanique pour le balayage du faisceau laser ou balayage par micromiroirs microélectromécaniques) qui limitent considérablement leur fiabilité. Il est nécessaire de développer des LiDARs sans pièces mobiles.

Parmi les technologies prometteuses pour les développer, il convient de mentionner les circuits intégrés photoniques (CIPs). Analogues aux puces électroniques qui transfèrent des signaux électriques, les CIPs sont des puces photoniques qui guident la lumière et permettent son balayage. Malgré son potentiel, cette technologie doit encore résoudre plusieurs problèmes, notamment sa faible efficacité à cause des pertes de lumière lors de son insertion dans la puce.

Une alternative aux CIPs sont les « scanners à métasurface ». Les métasurfaces sont des interfaces ultraminces structurées avec des ensembles d’éléments de tailles et d’espacements plus petits que la longueur d’onde d’illumination (de l’ordre de la centaine de nanomètres). Les métasurfaces sont apparues depuis 15 ans et ont révolutionné l’ingénierie de la lumière, par exemple sa déflection, en exploitant les interactions lumière-matière à l’échelle nanométrique. Dans leur version classique, les métasurfaces sont « passives », ce qui signifie qu’elles ne peuvent pas scanner dynamiquement un faisceau laser, mais plutôt qu’elles le dirigent vers une seule direction avec une efficacité maximale. Il est possible de rendre les métasurfaces actives en y incluant des matériaux dont les propriétés optiques peuvent être contrôlées par des stimuli externes tels que des tensions électriques. En exploitant la nanotechnologie et leur compatibilité avec les processus de fabrication utilisés dans les fonderies de semi-conducteurs, les “Métasurfaces Actives” semblent pouvoir apporter une nouvelle ère à la technologie de balayage LiDAR.

Au sein du groupe « Métasurfaces » du Centre de recherche sur l’hétéroépitaxie et ses applications (CRHEA-CNRS), nous développons de nouveaux schémas de balayage LiDAR basés sur la technologie des métasurfaces. Nous explorons également l’utilisation de matériaux accordables, tels que les cristaux liquides actuellement utilisés dans les écrans, pour développer de nouveaux modules et réaliser des LiDARs ultracompacts aux performances élevées. Le groupe « Métasurfaces » travaille en collaboration avec des start-up hébergées par le CRHEA pour ouvrir la voie aux « Métasurfaces Actives » à révolutionner la technologie LiDAR, rendant la France un acteur majeur de la transformation de cette technologie importante.![]()

Christina Kyrou, Docteure en physique et chercheuse postdoctorale en nanophotonique dynamique au CNRS, Université Côte d’Azur

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.